Panduan cepat untuk menulis file Robots.txt

Bagaimana Anda berkonsultasi dengan buku teks besar? Memilah-milah indeks. Nah: ada satu elemen yang merupakan ringkasan sebenarnya dari situs web Anda…

Satu-satunya cara untuk berhubungan dengan mesin pencari spider, atau crawler, adalah melalui file bernama robots.txt. Atau lebih baik. Saat Anda mengirimkan proposal situs web Anda ke Google, itu dihadapkan pada informasi yang sangat banyak.

Bagaimana Anda berkonsultasi dengan buku teks yang begitu besar sehingga Anda merasa tidak akan pernah menemukan semua yang Anda butuhkan? Anda berkonsultasi Indeks. Nah: file robots.txt adalah indeks situs web Anda.

Ini adalah dokumen yang mudah diisi yang memberi tahu perayap mesin telusur apa yang harus dicari. Singkatnya: Anda akan membantunya memahami terbuat dari apa situs Anda, sehingga algoritme dapat memberi Anda peringkat yang sesuai dengan pekerjaan yang telah Anda lakukan.

Adakah yang bisa menulis file robots.txt?

Jawaban singkatnya adalah ya. Jawaban jujurnya adalah tidak. Meskipun tata bahasa file robots.txt sangat sederhana, dan komposisinya terdiri dari beberapa baris, lebih baik mengandalkan perawatan webmaster ahli yang tahu di mana harus meletakkan tangannya. Lagi pula, kesalahan kecil sudah cukup untuk membahayakan posisi situs web Anda, dan karenanya menghentikan semua operasi SEO bahkan sebelum memulai.

Sebelum Anda mulai, ketahui satu hal: siapa pun dapat melihat file robots.txt dari situs mana pun dengan menulis /robots.txt setelah domain. Anda bahkan dapat berkonsultasi dengan Google!

Anda dapat menulis file seperti itu tanpa mengunduh perangkat lunak khusus. Bahkan, cukup menggunakan notepad Anda dan simpan, coba tebak, dalam format .txt.

Mari kita tulis bersama robots.txt: header

Mari kita mulai dari awal, karena selalu logis untuk melakukannya. Pembukaan file, atau lebih tepatnya header, sepenuhnya didedikasikan untuk nama laba-laba, didahului dengan kata-kata kecil yang selalu sama. Misalkan Anda ingin diperhatikan oleh Google. Jadi baris pertama akan menjadi:

Agen-pengguna: Googlebot

Baris yang sangat pendek ini memberi tahu Google bahwa semua yang mengikutinya pasti akan menarik baginya. Jika Anda ingin semua perayap yang membaca jenis file ini dapat melihat dokumen, gantikan Googlebot dengan * sederhana, tanda bintang.

Sekarang setelah Anda menunjukkan laba-laba yang mana, yaitu SIAPA, Anda perlu menunjukkannya juga APA yang harus dia baca.

Setiap baris kode, menurut definisi, sesuai dengan tindakan mesin. Tak perlu dikatakan bahwa setiap perintah dalam file robots.txt sesuai dengan apa yang seharusnya tidak dilakukan oleh mesin. Dan ini adalah kunci yang memungkinkan Anda menulis yang benar-benar efektif. Kita berbicara tentang perintah DISALLOW.

Apa itu perintah DISALLOW?

Il melarang perintah memungkinkan Anda untuk alasan dengan pengecualian. Dengan kata lain, ketika dikatakan bahwa pertama-tama mengatakan apa yang tidak boleh dilakukan – ya, Anda bernalar dengan pengecualian. Selain larangan, ada juga yang mengizinkan, yang merupakan pengecualian dari pemblokiran.

Jika Anda ingin menulis file robot yang bagus, Anda harus berpikir sebaliknya, jadi Anda harus memberi tahu Google apa yang tidak boleh dibaca. Jika Anda menulis:

Larang:

Laba-laba akan membaca seluruh situs Anda, tanpa rem.

Jika setelah "Disallow:" Anda memasukkan garis miring (oleh karena itu Disallow: /), situs tersebut tidak akan masuk ke mesin pencari, titik.

Larang: /direktori/

Ganti direktori kata dengan folder yang ingin Anda tolak dari tampilan spider. Anda dapat melakukan hal yang sama dengan file tertentu.

Larang: /myfile.html

Perhatian untuk tanda baca dan huruf, huruf besar atau huruf kecil. Jenis file ini sangat menghargai "hal-hal sepele" semacam ini, tetapi mereka membuat perbedaan besar.

Mengapa Anda menghentikan Google membaca sebagian besar situs Anda? Saat Anda menulis file jenis ini, penting untuk memahami file mana yang tidak boleh muncul di mesin pencari, tetapi tanpa menyalahgunakannya. Namun, ketahuilah bahwa siapa pun yang mengetahui alamat pasti dari file tersebut akan dapat mengaksesnya dalam hal apa pun.

Apa itu perintah MENGIZINKAN?

Dalam file Anda dapat menambahkan pengecualian dengan perintah MENGIZINKAN. Tata bahasanya identik, tetapi itu akan membuat beberapa pengecualian pada DISALLOW yang memungkinkan untuk membuka margin eksplorasi yang menarik bagi laba-laba.

Contoh file kecil:

Agen-pengguna: Googlebot

Larang: /gambar/

Izinkan: /images/holidays.jpg

Pada dasarnya kami memberi tahu Googlebot untuk tidak mempertimbangkan folder gambar, kecuali foto tertentu di dalamnya, yaitu foto liburan.

Dan itu, teman-teman, itu dia. Kami menulis file robots.txt pertama kami. Tentu, apa yang akan kita lakukan untuk situs yang sebenarnya mungkin sedikit berbeda, tapi tidak banyak. Jika ragu, selalu dapatkan saran dari webmaster khusus. Kami menyarankan Anda untuk mencoba menulisnya sendiri, pertama-tama, dan mengirimkannya kepadanya untuk diperiksa, untuk menguasai dasar-dasarnya dan lebih memahami cara kerja situs Anda.

Apa korelasi antara robots.txt dan peta situs?

Sitemap adalah file yang dihasilkan oleh plugin khusus yang berisi semua tautan di situs. Saat laba-laba memasuki situs, pertama-tama ia membaca robot, lalu merayapi situs tersebut. Jika selama perayapan robot menemukan alamat peta situs, seluruh proses akan jauh lebih mudah.

Tambahkan kode berikut ke kode di atas:

Peta Situs: http://www.ilnomedeltuositobellissimo.com/sitemap.xml

Sbg penutup

Semua file robot sama. Ini berarti file Robot yang ditulis untuk Google juga akan berfungsi dengan baik untuk Bing, dan mengikuti tata bahasa yang sama.

File robots.txt yang terorganisir dengan baik memungkinkan Anda melakukannya menghemat waktu perayap. Jangan berkecil hati: ini adalah langkah pertama menuju kesuksesan!

Anda mungkin juga tertarik pada:

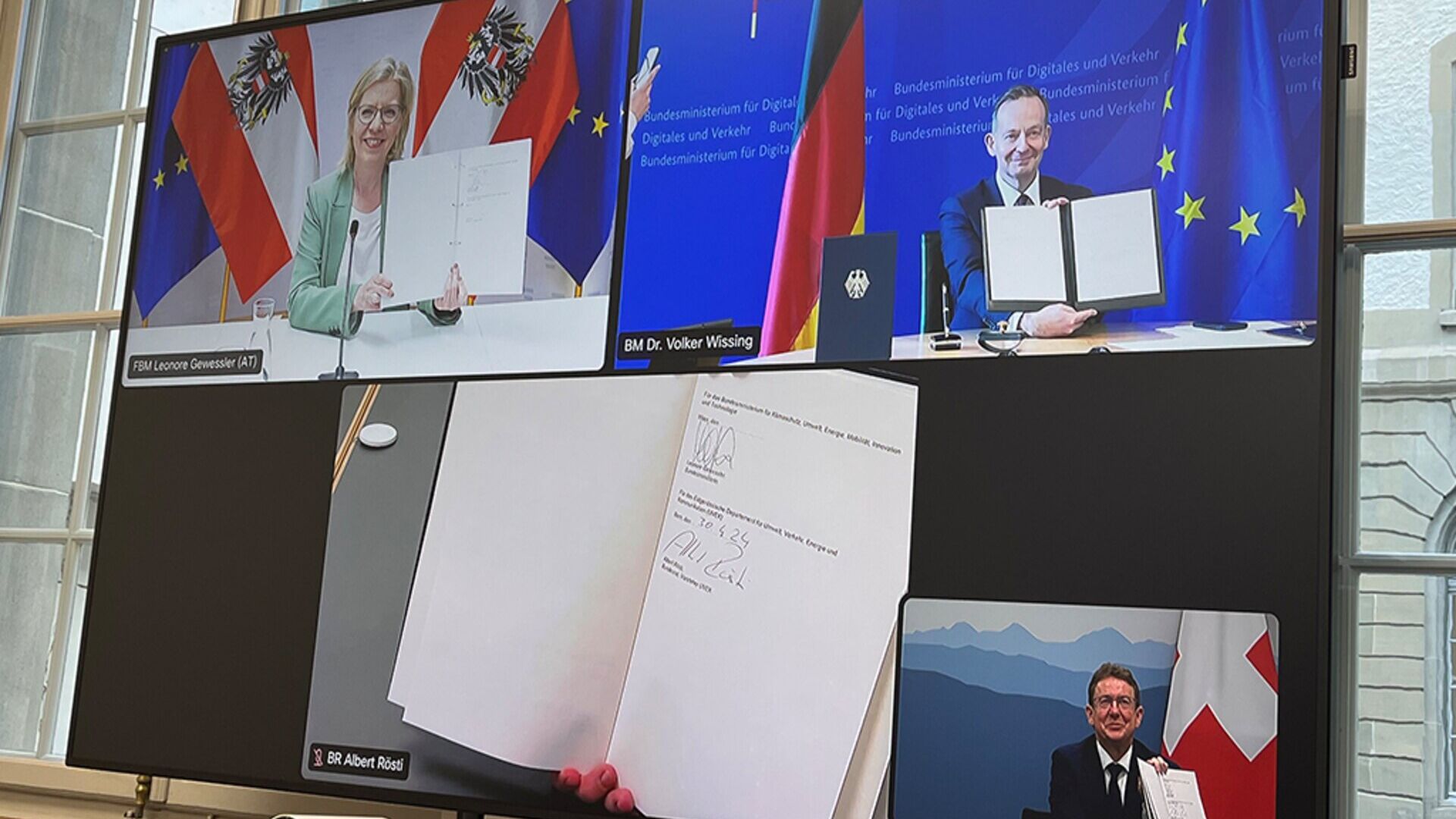

Austria, Jerman dan Swiss untuk jalur kereta kargo yang "lebih inovatif".

Menteri DACH Leonore Gewessler, Volker Wissing dan Albert Rösti: pengenalan Pemasangan Otomatis Digital adalah elemen kunci

Persuasi atau manipulasi? Kejadian dan dampak sejarah PR

Beginilah cara Public Relations, mulai dari dialog canggih Yunani kuno hingga era digital saat ini, terus menawarkan inovasi berkelanjutan

Kaum muda dan mata uang kripto: cara mengetahui lebih banyak tentang Bitcoin…

Memperkenalkan anak-anak pada mata uang digital dan Blockchain dapat menjadi upaya yang menarik, mengingat ketertarikan mereka terhadap teknologi dan inovasi

“Pasien di tengah”: harapan besar dan pertemuan di Senat

Topik tentang pentingnya inovasi perangkat medis untuk layanan kesehatan Eropa akan dieksplorasi pada tanggal 15 Mei di Roma oleh para ahli dan politisi

oleh Alberto NicoliniEditor districtbiomedicale.it, Berita BioMed dan Radio Pico